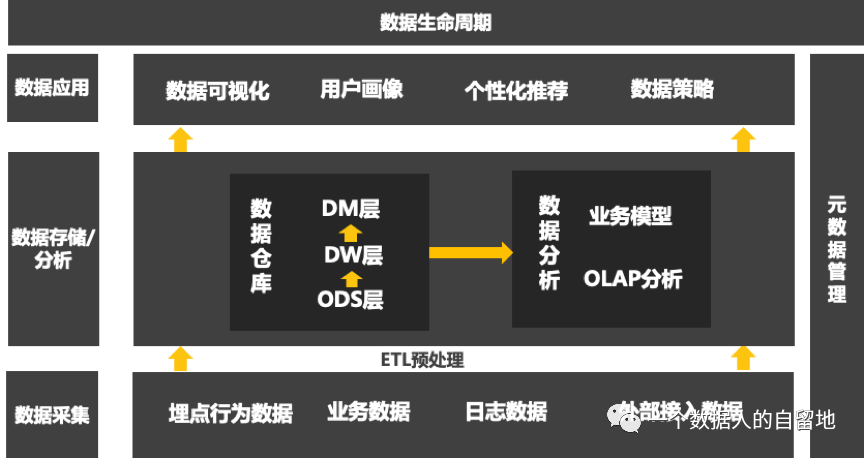

实战案例 |如何参照阿里OneData构建数据指标体系?接下来我们聊聊数据全生命周期。

接下来分别介绍这几大模块:

1.数据采集

2.数据预处理——ETL

3.数据存储——数仓

4.数据分析——OLAP/业务模型

01数据采集

按数据来源分,可将数据分为如下几个类型:

埋点行为数据:通过埋点的方式,采集到的一些行为数据,如浏览、点击、停留时长等

业务数据:伴随着业务产生的数据,核心是生产系统内存储的业务表单数据

日志数据:一般是web端日志记录的数据

外部接入数据:从第三方获得的数据

按数据类型可分为:结构化数据、半结构化数据、非结构化数据。

结构化数据

一般是从内部数据库和外部开放数据库接口中获得,一般都是存储产品业务运营数据以及用户操作的结果数据,比如注册用户数、下单量、完单量等数据。这类数据格式规范,典型代表就是关系数据库中的数据,可以用二维表来存储,有固定字段数,每个字段有固定的数据类型(数字、字符、日期等),每个字节长度相对固定。这类数据易于维护管理,同时对于查询、展示和分析而言也是最为方便的一类数据格式。

半结构化数据

应用的点击日志以及一些用户行为数据,通常指日志数据、xml、json等格式输出的数据,格式较为规范,一般是纯文本数据,需要对数据格式进行解析,才能用于查询或分析数据。每条记录预定义规范,但是每条记录包含信息不同,字段数不同,字段名和字段类型不同,或者还包含着嵌套的格式。

非结构化数据

指非纯文本类数据,没有标准格式,无法直接解析相应值,常见的非结构化数据有富文本、图片、声音、视频等数据。这类数据除非是要进行高级的文本挖掘或者多媒体数据挖掘,否则对于日常的数据统计与分析而言,非结构化数据没有分析价值。一般不会将非结构化数据以二进制形式存入数据仓库,数据仓库之父Inmon的建议是数据仓库中只需要存储非结构化数据的元数据。一般将非结构化数据存放在文件系统中,数仓中记录数据的信息,如标题、摘要、创建时间等,方便进行索引查询。

02数据预处理——ETL

ETL即Extract Transform Load,描述数据抽取、转换、加载的过程。

数据抽取:把数据从数据源中读出来

数据转换:把原始数据转换成期待的格式和维度

数据加载:把处理后的数据加载到目标处,如数据仓库中

数据仓库从各数据源获取数据以及在数据仓库内的数据流转和流动都可以认为是ETL过程,ETL是数据仓库的流水线,也可以认为是数据仓库的血液,它维系着数据仓库中数据的新陈代谢,而数据仓库日常的管理和维护工作大部分精力是保持ETL的正常和稳定。

Kettle

Kettle是常用的ETL处理开源免费工具,其中文名叫水壶,该项目的主程序员MATT希望把各种数据放到一个壶中,然后以指定的格式流出。Kettle是纯Java编写,可以在Windows、Linux、unix上运营,数据抽取效率高效稳定,开放源代码,便于二次开发包装。但其数据抽取速度和大数据处理方面的能力比起informatica、datastage等商业软件要慢。

03数据存储——数据仓库

数据仓库的目的是构建面向分析的集成化数据环境,为企业提供决策支持。数据仓库本身不生产任何数据,同时也不消费任何数据,数据来源于外部,并且开放给外部应用。这就是为什么叫数据仓库,而非数据工厂的原因。数据仓库基本架构包含数据流入/流出的过程,可以分为三层:源数据、数据仓库、数据应用

ODS(Operational Data Store)数据操作层

用于原始数据在数据平台的落地,这些数据从数据结构、数据之间的逻辑关系上都与雨啊是数据层基本一致。在源数据进入这一层时,通常要进行数据清洗,如业务字段提取、去掉不用字段、脏数据处理等。默认保留近30天的数据,表命名规范为:ods主题原表名。

DIM(Dimension Data Layer),数据维度层

主要用于存储公共的信息数据,如地理位置、时间,数据格式一般是维表,如以国家ID等字段为主键,按需存储,保留历史至今的所有数据,表命名规范为:dim_业务描述,如dim_time。

DWD(Data Warehouse Detail)数据明细层

用于源系统数据在数据平台中的永久存储,用以支持DWS层和DM层无法覆盖的需求。默认保留历史至今的所有数据,表命名规范为:dwd主题域描述,如dws_driver_detail 司机个人信息表。

DWS(Data Warehouse Service),数据汇总层

主要包含两类汇总表,一是细粒度的宽表,二是粗粒度的汇总表。例如打车业务,包含基于订单、乘客、司机、车辆等细粒度的宽表和基于维度组合如(用户日下单量汇总、用户日完单量汇总、司机日接单量汇总)的粗粒度汇总表。DWS层的汇总数据目标时满足80%的业务计算,默认保留历史至今的所有数据,表命名规范为:dws主题域描述,如dws订单今日下单量。

DM:数据集市层

按照业务主题构建,面向特定部门或人员等数据集合,如产品、运营、客服等,用于支持BI、多维分析、营销推荐、标签、数据挖掘和其他数据服务。默认保留历史至今的所有数据,表命名规范为:dm主题域描述。

数据仓库有4大特性:主题性、集成性、稳定性、动态性。

为什么要面向主题?

面向主题是数据仓库的第一特性,主要指合理的组织数据以方便实现分析。对于源数据而言,数据组织形式是多样的,如点击流数据格式是未经优化的,前台数据库基于OLTP操作组织,不适合直接进行分析,而整理成面向主题的形式,才方便分析。如点击流日志整理成页面、访问、用户三个主题,可以明显提升分析效率。

为什么集成?

数据仓库中存储的数据是来源于多个数据源的集成,原始数据来自不同的数据源,存储方式各不相同。

为什么稳定?

数据仓库汇总保存的数据是一系列历史快照,不允许修改,用户只能通过分析工具进行查询。

为什么动态?

数据仓库会定期接收新的集成数据,反映出最新的数据变化。当数据超过数据仓库的存储期限时,或对分析无用时,会从数据仓库中删除这些数据,数据仓库的结构和维护信息存储在数据仓库的元数据中。

Hive

主流的数据仓库,在国内常用的是一款开源数据仓库hive。Hive是基于Hadoop的数据仓库工具,可以对存储在HDFS的文件数据集进行查询和分析处理。Hive对外提供了类似于SQL语言的查询语句hiveQL,在做查询时,将HQL语句转换成计算模型。Hive的主要优势是免费,而商业收费数据仓库有Teradata、Oracle、Db2等。

04数据分析

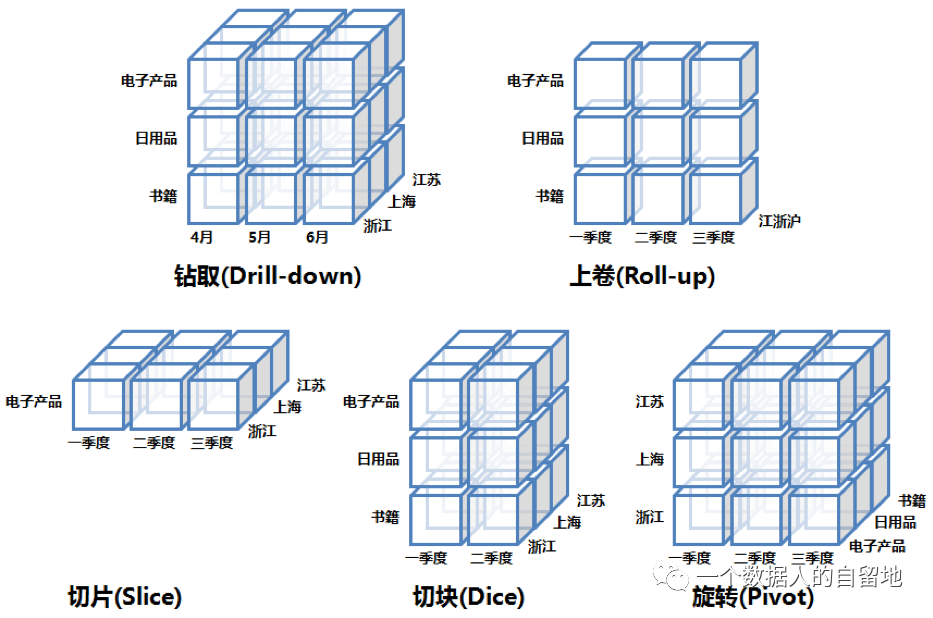

1.OLAP

也被称为多维分析,提供多维数据管理环境,其典型应用是对商业问题的建模与商业分析。

1993年,关系数据库支父F.Codd提出OLAP概念,同时提出OLAP的12条准则。使得分析人员能够从多角度对信息进行快速、一致、交互的存取。

目标:满足决策支持或者满足在多维环境条件下特定的查询和报表需求,核心技术是“维”的这个概念。“维”是人们观察客观世界的角度,是一种高层次的类型划分。

OLAP的多维分析操作:钻取、上卷、切片、切块、切块、旋转、透视、排序、筛选。

钻取:在维的不同层次间的变化,从上层降到下一层,比如通过对2020年第二季度的总销售额数据进行钻取,查看2010年第二季度4、5、6每个月消费数据;也可以钻取浙江省查看杭州、宁波等城市销售数据。

上卷:钻取的逆操作,细粒度向高层聚合,如将江苏、上海、浙江省的销售数据汇总查看江浙沪地区的销售数据。

切片:选择维中特定的值进行分析,比如只选择电子产品的销售数据。

切块:选择维中特定区间的数据或者某批特定值进行分析,比如选择电子产品和日用品的销售数据。

旋转:维的位置互换,就像二维表行列转换,通过旋转实现产品维和地域维的互换。

优势:基于数据仓库面向主题的、集成的、保留历史不可变更的数据存储,以及多维模型多层次的数据组织形式。

2.业务模型

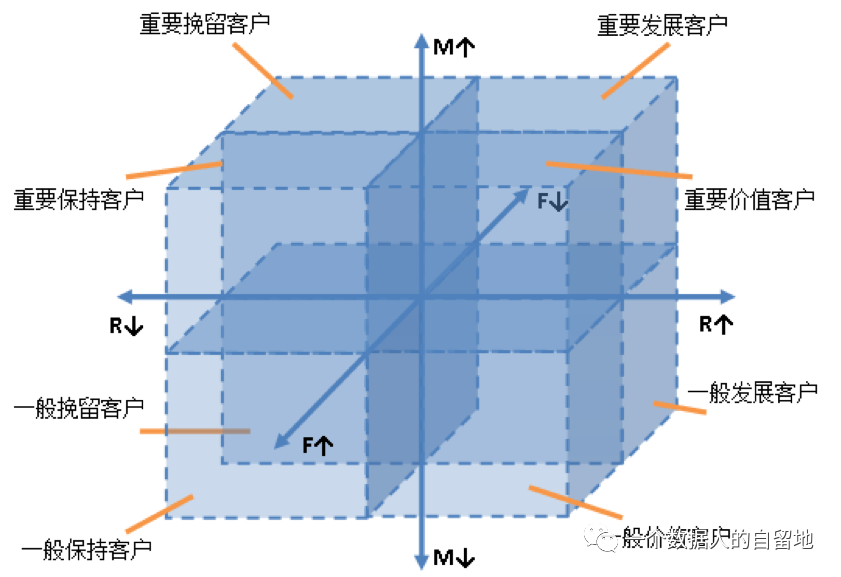

基于某些数据分析和决策支持而建立起来的数据模型,如用户评价模型、关联推荐模型、RFM分析模型、漏斗模型、用户行为路径模型、用户分群模型、留存分析模型等。接下来介绍一个常用的模型RFM模型,其他的业务模型在后续篇章进行展开。

RFM模型

根据美国数据库营销研究所Arthur Hughes的研究,客户数据库中有3个神奇的要素,这3个要素构成了数据分析最好的指标。

最近一次消费(Recency):指用户上一次购买的的时间,理论上上一次消费时间越近的顾客是比较好的顾客,是维系顾客的一个重要指标。。

消费频率(Frequency):顾客在限定时间周期内消费的次数。最长购买的顾客,也是满意度最高的顾客。根据这个指标,可以把客户分成5等份,相当于划分了一个忠诚度的阶梯。

消费金额(Monetary):消费金额时产能最直接的衡量指标,也可以验证“帕雷托法则”,公司的80%收入来自于20%的顾客。

客户类型可划分为:

1)重要价值客户:RFM比较大、优质客户,需要保持;

措施:倾斜更多资源、VIP服务、个性化服务、附加销售

2)重要唤回客户:消费金额和消费频次大,但最近无消费,需要唤回;

措施:提供有用资源,通过续订或更新产品赢回他们

3)重要深耕客户:消费金额大贡献度高,且最近有交易,需要重点识别;

措施:交叉销售,提供会员/忠诚计划,推荐其他产品

4)重要挽留客户:消费金额大,潜在有价值客户,需要挽留

措施:push消息触达,回访,提高留存率

5)潜力客户:消费频次高,且最近有消费,需要挖掘

措施:向上销售更高价值的产品

6)新客户:最近有消费,接触的新客户,有推广价值

措施:开展活动,免费试用,提高客户兴趣,建立品牌认知度

7)一般维持客户:消费频次多,但贡献不大,一般维持

措施:积分制,分享宝贵的资源,以折扣推荐热门产品/续订,与他们重新获得联系

8)流失客户:FM值均低于平均值,最近也没消费,相当于流失

措施:恢复客户兴趣,暂时放弃无价值用户

总结

本文主要讲数据采集、ETL数据预处理、数据仓库、OLAP数据分析与业务模型,帮助大家进行技术上的扫盲,后续会介绍业务模型以及BI数据应用。

发表评论 取消回复